環境:LM Studio 0.3.37

ローカルLLMにウェブ検索をさせて新しい情報を取得させたり、まとめさせたり、調査させる方法です。今回はWebSearch-MCPをインストールし、LM Studioで利用します。

動機

ローカルLLMモデルとの会話は、昔のことしか知らない引きこもりの賢者と話しているような感じがあります。リアルタイムにウェブ検索をできるようにして、調べた内容をもとに深堀していく、といったことができるようにしたい。外の世界へ出てもらって情報を取ってくるエージェントのような存在になって欲しい。

インストールと設定の手順

前提条件

Gitをインストールしておく

Node.jsをインストールしておく

WebSearch-MCPをインストールする

WebSearch-MCPを選択した理由はAPIが不要だからです。とりあえず始めるにはよいかと思いました。

任意の場所にGit Cloneする。(例:D:/GenerativeAI/に設置する)

READMEの通りに進めていく。

git clone https://github.com/mrkrsl/web-search-mcp.gitweb-search-mcpフォルダに入り、以下を実行

npm installnpm installは「このフォルダで必要な部品一式を自動でそろえる」コマンド(npm = Node Package Manager)

node_modules/というフォルダが作成され、ライブラリが保存される。

つづけてplaywrightをインストールする。

※Microsoftが開発したWebアプリケーションのテストやブラウザ自動化を効率的に行うためのオープンソースフレームワーク。

npx playwright installつづけてビルドする。

npm run buildサーバーを起動する

※手動でやらなくてもLM Studioのほうでサーバーを起動してくれている可能性あり。

node .\dist\index.js終了するにはCtrl + C。

LM Studioの設定

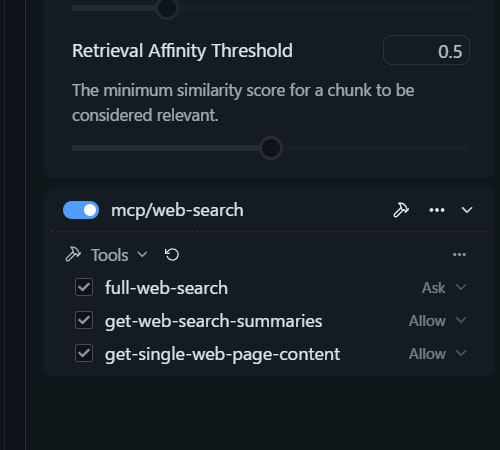

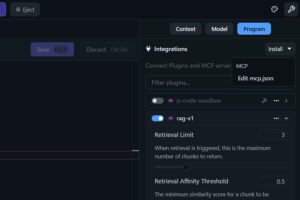

右上のProgramsのところのInstallタブから、Edit mcp jsonを選ぶ。

このように、ファイルの場所を指定する。

{

"mcpServers": {

"web-search": {

"command": "node",

"args": [

"D:/GenerativeAI/web-search-mcp/dist/index.js"

],

"cwd": "D:/GenerativeAI/web-search-mcp"

}

}

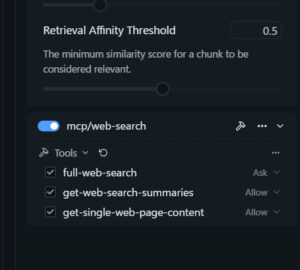

}上手くいくとmcp/web-searchが追加される。

これで準備が整いました。

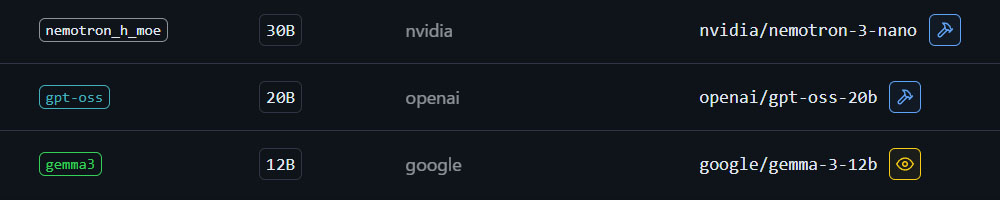

使用するモデルはトンカチマークのあるTool Use 対応モデルを選びます。WebSearch-MCPはQwen3やGemma3が推奨されてました。コンテキスト長は多めに取っておく。ウェブ検索で取得する情報で消費する。

検索例

株式市場の動向を調べる

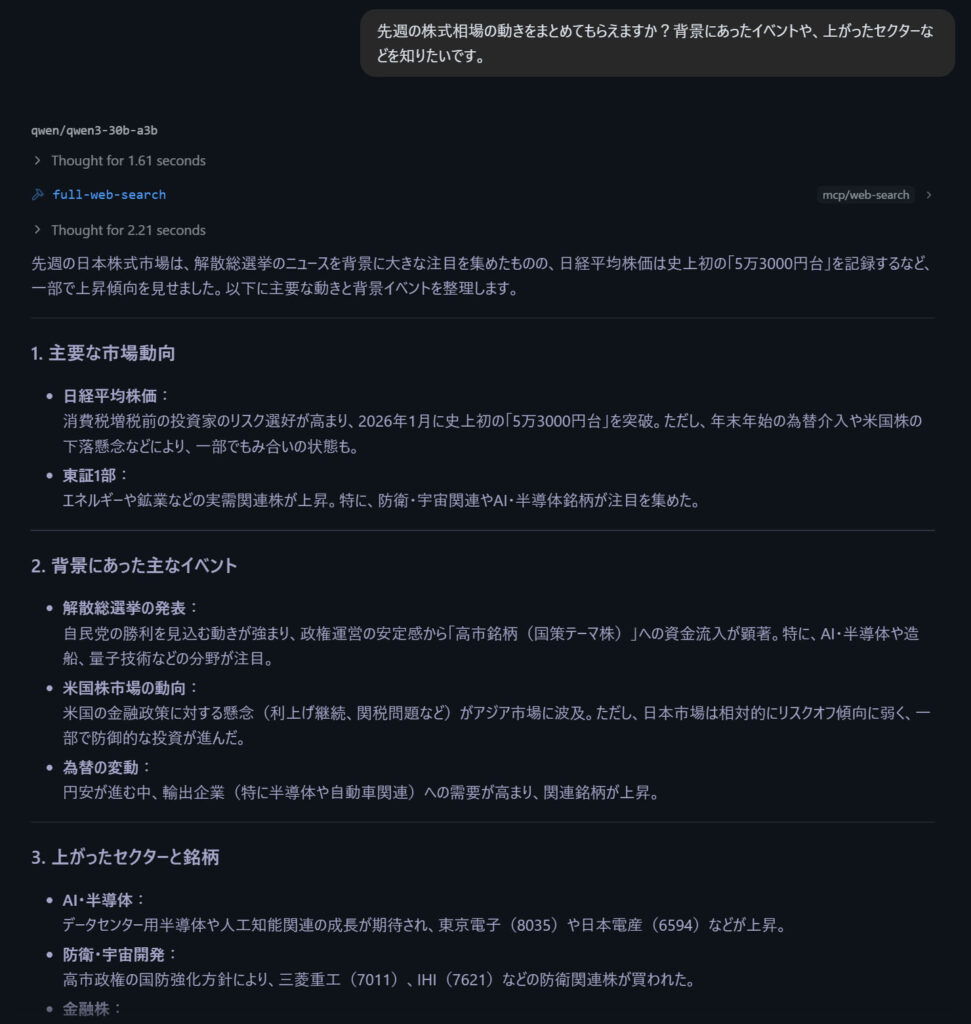

「先週の株式相場の動きをまとめてもらえますか?背景にあったイベントや、上がったセクターなどを知りたいです。」と入力。Qwen3-30B-A3Bにまとめてもらいました。

よい感じにまとめてくれています。自分だけのファイナンシャルプランナーを育成してみたいですね。

個別銘柄について調べる

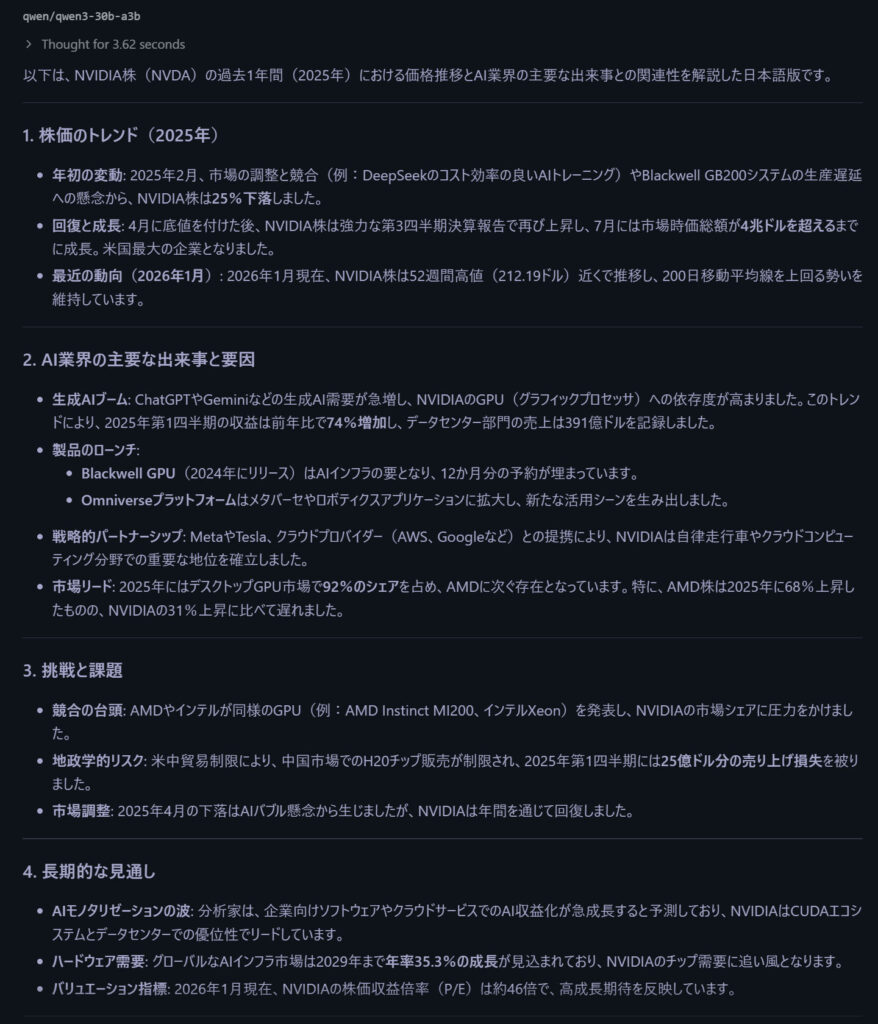

「nVidia株のこの1年の価格推移をAI業界のイベントと合わせて解説してもらえますか?」と入力して解説してもらう。

DeepSeekショックから、中国への輸出規制、データセンターへの需要、等々、内容は概ね正しいように思う。2025年4月の下落はトランプの関税ショックによるものだと思うが、まあ、よいか。

メモリの価格を調べる

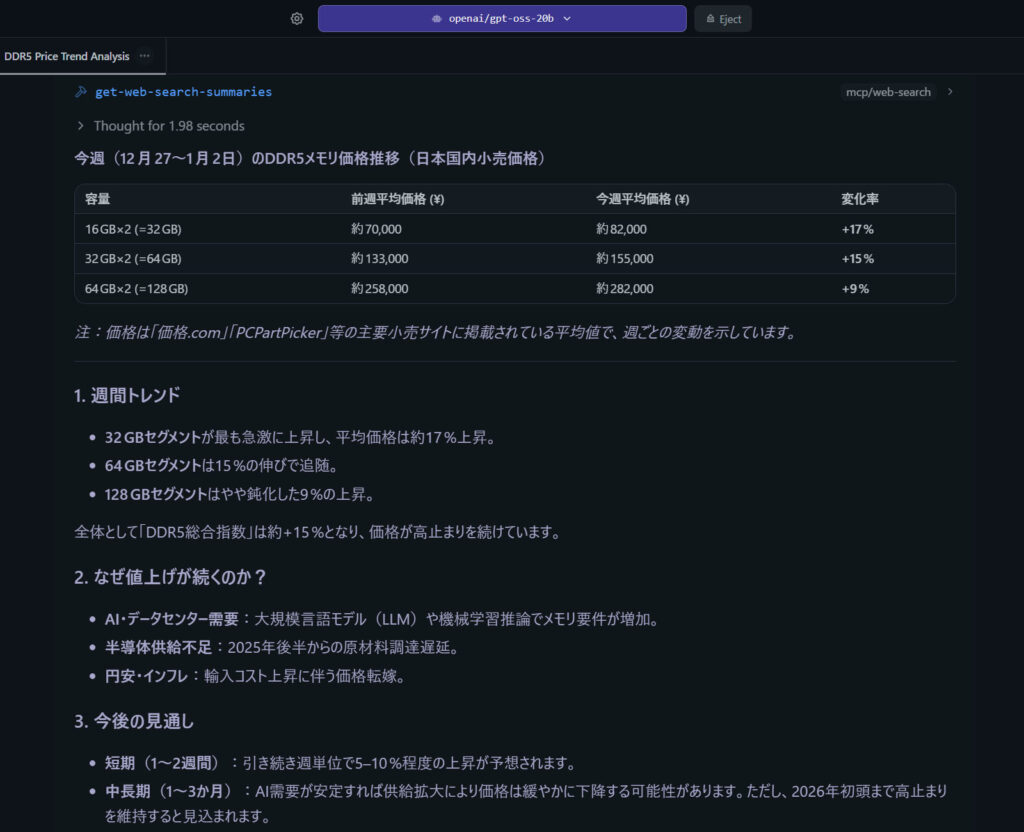

「今週のDDR5メモリの価格推移を教えてください。」と入力。

年始に128GBメモリを去年の3倍の価格で買って悔しい思いをしたのだが、今後もどうなるか気になります。自分の予想では以前の水準まで下がることは数年先までないと思っています。

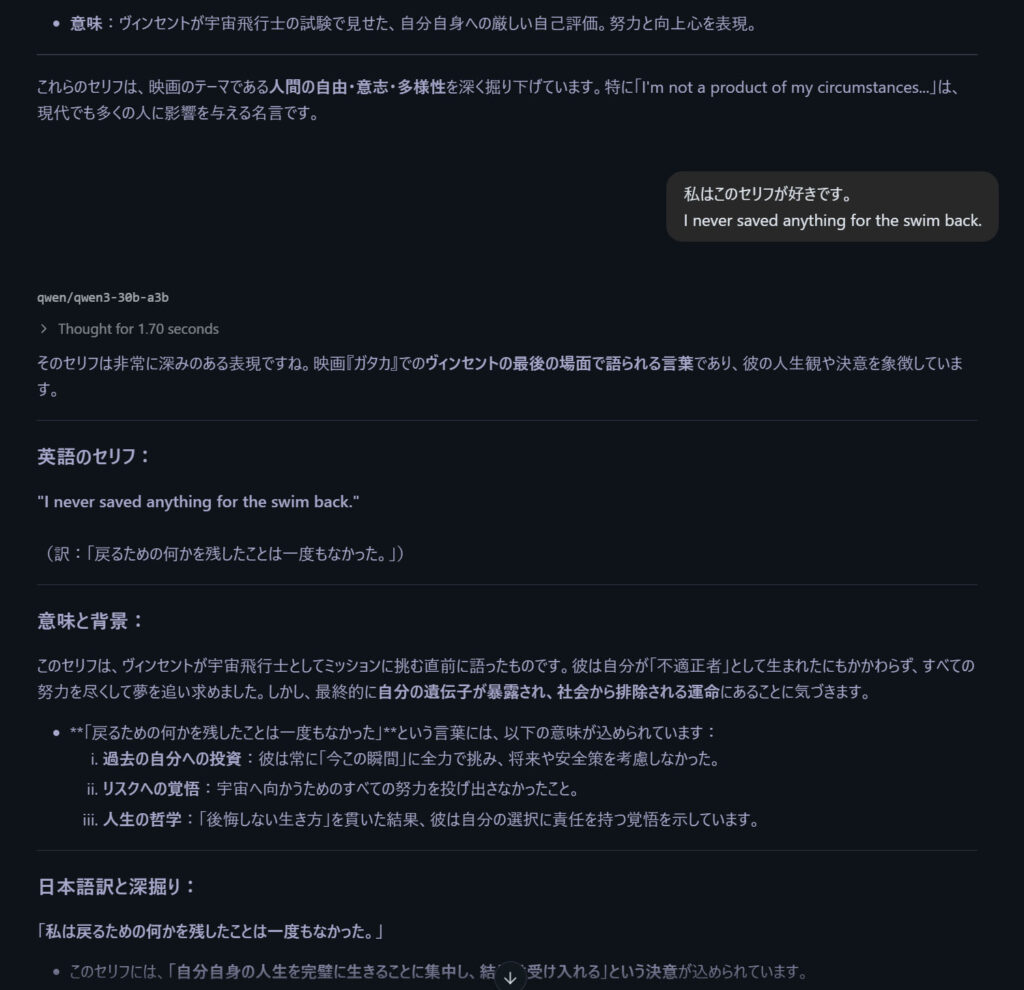

映画について語る

知らないことがあると、わかった振りをして適当なことを書くのではなく、調べてくれるようになった。

感想

ローカルLLMが大幅にクオリティアップし、使い方の幅が一段と広がったように思います。

自分だけのリサーチエージェントを作ってみたいですね。また、無規制版モデルを使うことで調べる対象の幅も広がりそうです。