環境:Visual Studio Code 1.108.2, Claude Code

Claude Codeの力を借りて、ローカルLLMモデルを利用したアプリ開発を始めてみました。チャットボットを作ってみたいというのが強い動機です。

チャットボットを使って作ったら面白そうなアプリのアイデアはいろいろあるのですが、まずはStable Diffusionで生成した画像とプロンプトをレビュー・修正・提案するものを作ってみようと思いました。

きっかけ

Stable Diffusionを始めたときに苦労したのはプロンプトでした。適切な単語を探すために、ウェブを検索してプロンプトのリストが載ったサイトを探したりと、やたらと時間を使いました。LLMが画像とプロンプトを同時にレビューして、さらに支援もしてくれたら楽なのになーと思ってたので、そんな悩みを解決するものを目標としてみました。

できること

プロンプトの改善

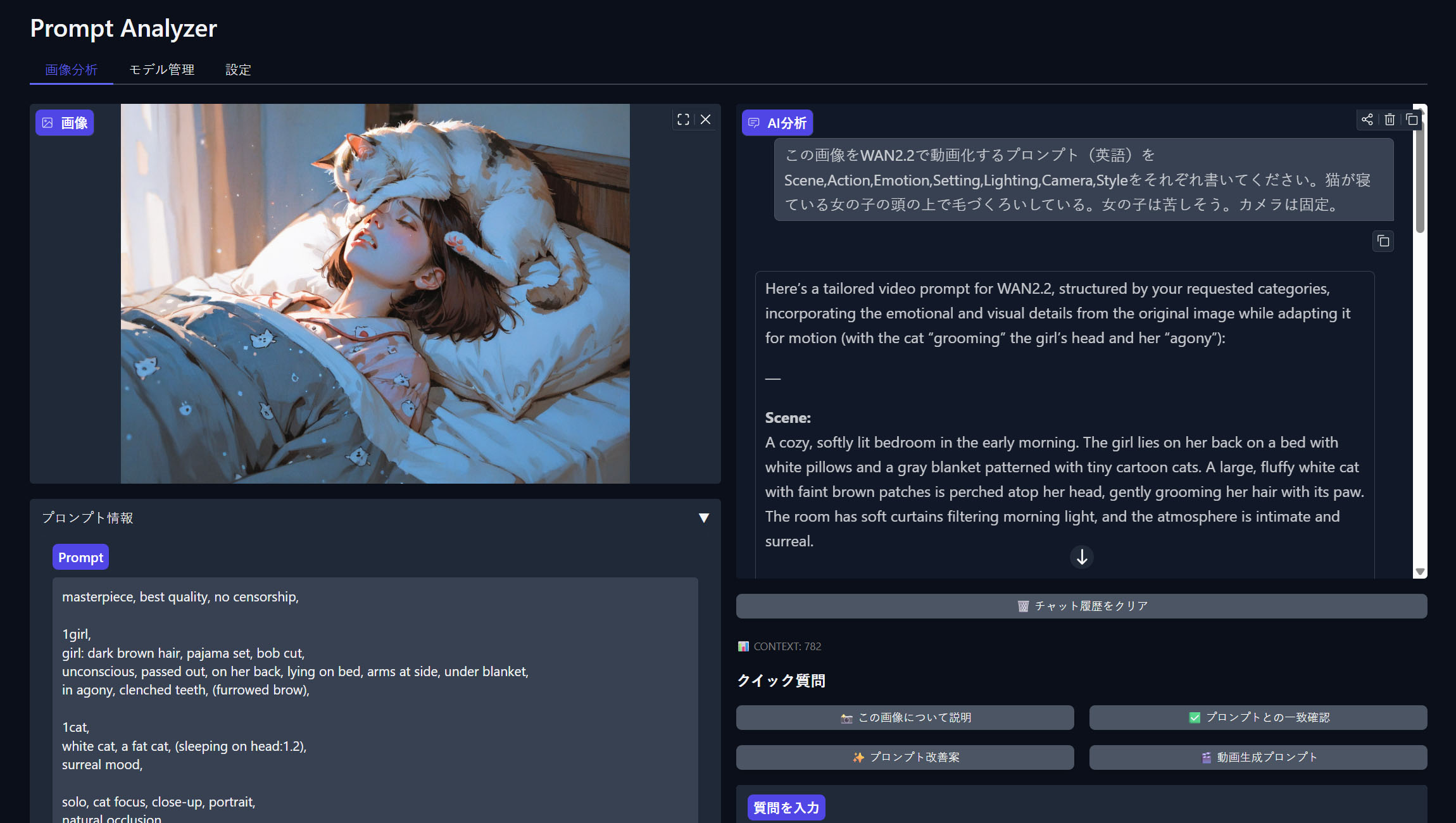

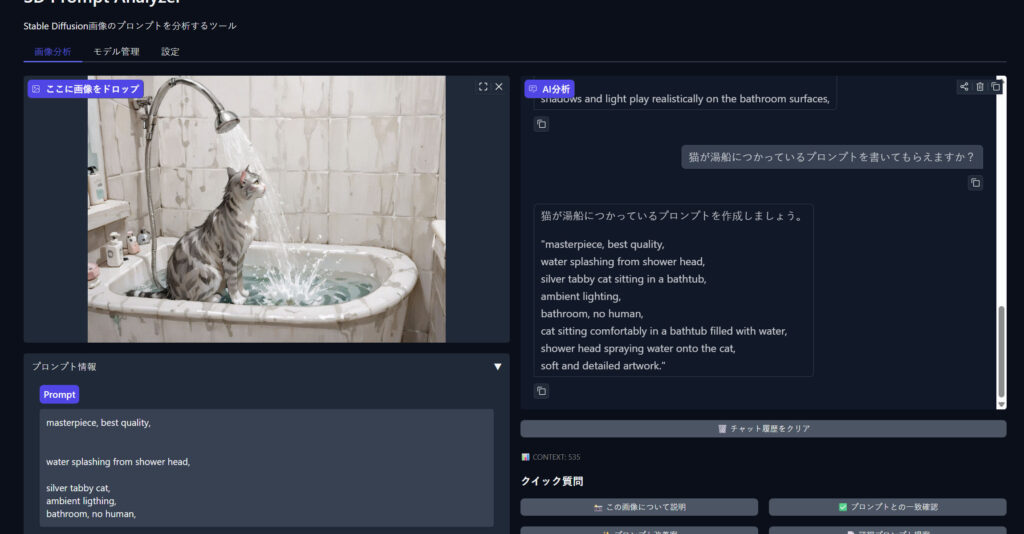

Qwen-3とQwen-2.5のビジョンモデルを使っています。画像そのものの評価ができるので、プロンプトとの整合性を評価してもらえます。また修正したプロンプトも依頼することができます。

「湯船に浸かっているプロンプトに変更して」と頼めば、元のプロンプトを修正する形で返してくれる。

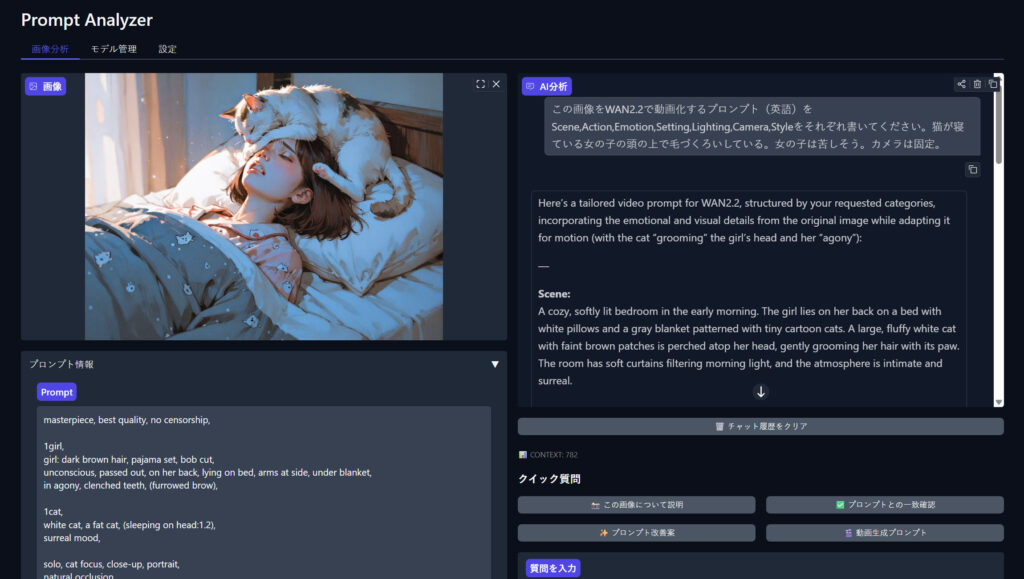

動画プロンプトの生成

プロンプトを元に動画生成用のプロンプトを書いてくれます。すでにある情報はプロンプトと画像から自動で書いてくれます。これは予想外の産物でした。

仕様

リポジトリはこちら

Gradio:機械学習モデル向けのWeb UI作成ライブラリ

PyTorch:機械学習(深層学習)ライブラリ

pillow:画像処理ライブラリ

huggingface-hub:Hugging Face Hubから モデル・データセットを取得・管理

qwen-vl-utils:Qwen系の Vision-Languageモデル向け補助ツール

torchvision:画像処理・CV向けPyTorch拡張ライブラリ

Qwen VLモデルについて

今回のアプリに利用しているモデル。視覚(画像・動画)とテキストを統合して理解・生成できるマルチモーダルAIモデル。

Qwen2.5-VL

Qwen2.5-VLは、視覚(画像・動画)とテキストを統合して理解・生成できるマルチモーダルAIモデル。

| 正式名 | Qwen2.5-VL |

| 公開日 | 2025年2月19日 |

| 開発会社 | Alibaba |

| モデル規模 | 3B / 7B / 72B |

Qwen3-VL

Qwen3世代のマルチモーダルモデル(視覚+言語対応)。Qwen2.5-VL と比べて、視覚とテキストの統合理解性能が大きく向上している。

| 正式名 | Qwen3-VL |

| 公開日 | 2025年9月23日 |

| 開発会社 | Alibaba |

| モデル規模 | 2B / 4B / 8B / 30B / 32B / 235B |

容量

| モデル | 容量 |

| Qwen-2.5 VL 3B | 7.0GB |

| Qwen-2.5 VL 7B | 15.5GB |

| Qwen-3 VL 4B | 8.3GB |

| Qwen-3 VL 8B | 16.3GB |

感想

Stable DiffusionやWANと同時に使うとだいぶ便利です。いちいちChatGPTにプロンプトの質問をするのって面倒なんですよね。ちょっとした需要にこそローカルLLMの威力が発揮されます。

今回もClaude Codeにほぼ作ってもらいました。こちらが勉強させてもらっている感じです。去年はAIのコード支援に感動していましたが、Claude Codeはそれを超えるレベルですね。もはやこれこそエージェントだと思います。